Neues DeepSeek V3-0324 Modell fordert GPT-4o und Claude-3.5 heraus

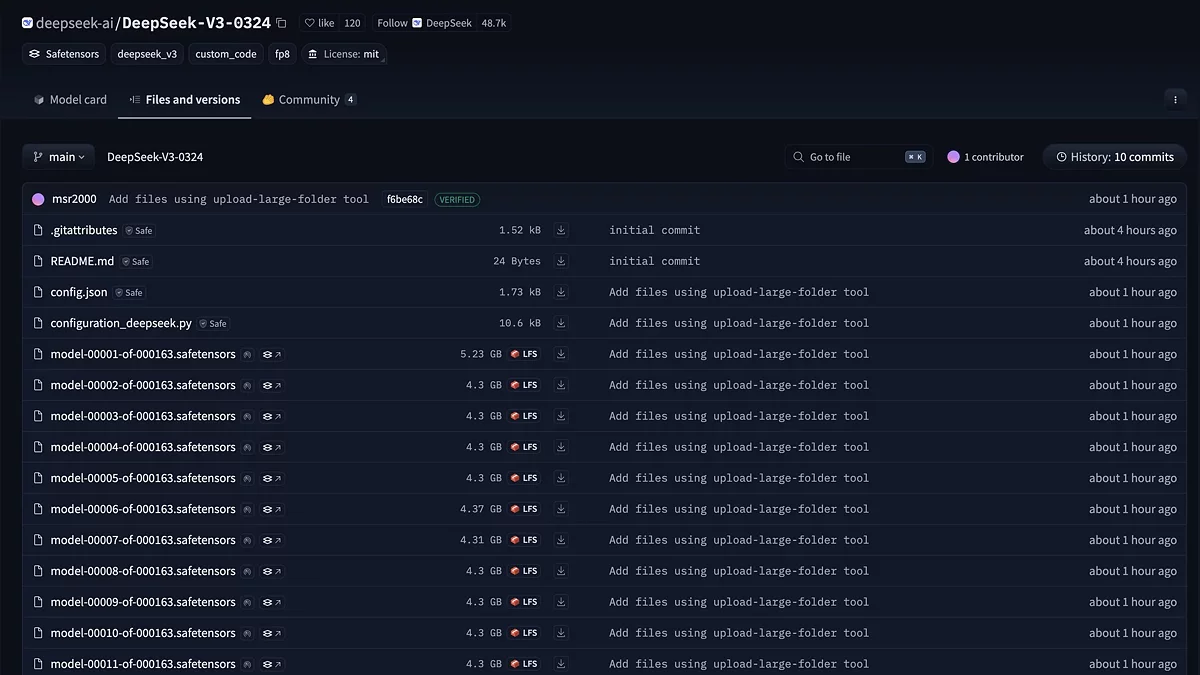

DeepSeek AI hat ein großes Upgrade für sein Flaggschiff-Modell — DeepSeek V3-0324 — angekündigt. Das Modell, das auf GitHub und Hugging Face verfügbar ist, holt nicht nur auf, sondern übertrifft auch geschlossene Alternativen wie GPT-4o und Claude-3.5-Sonnet in mehreren wichtigen Bereichen.

Im Mittelpunkt des Updates steht eine verbesserte Mixture-of-Experts (MoE) Architektur, bei der 671 Milliarden Parameter dynamisch in 37 Milliarden pro Token aktiviert werden. Die Multi-Head Latent Attention-Technologie reduziert den Speicherverbrauch um 60%, während die Multi-Token-Vorhersage die Geschwindigkeit der Textgenerierung um das 1,8-fache steigert. Das Modell wurde mit einem Datensatz trainiert, der mathematische Probleme, Code in 15 Sprachen und wissenschaftliche Arbeiten umfasst. Das Training dauerte 2,788 Millionen GPU-Stunden auf H800-Clustern — das entspricht 318 Jahren kontinuierlicher Arbeit auf einem einzelnen Beschleuniger. Das Ergebnis: 89,3% Genauigkeit beim Lösen von mathematischen Problemen auf Schulniveau (GSM8K) und eine Erfolgsquote von 65,2% bei der Codegenerierung (HumanEval) — 10–15% höher als bei vorherigen Open-Source-Lösungen.

Das Update hat einige unerwartete Verbesserungen gebracht:

- Die Frontend-Codegenerierung produziert jetzt visuell ansprechende Schnittstellen;

- Die Textqualität hat ein menschliches Niveau der Flüssigkeit in langen Essays erreicht;

- Die Genauigkeit beim Funktionsaufruf hat 92% erreicht und damit eines der Hauptprobleme früherer Versionen gelöst.

Während die offiziellen Update-Notizen noch nicht veröffentlicht wurden, wird die Größe des Modells mit 700 GB angegeben. Es ist über eine API mit einem einzigartigen „Temperaturkalibrierung“-System verfügbar: Der Standardparameter von 1,0 wird automatisch auf ein optimales 0,3 angepasst. Für die lokale Bereitstellung erhalten Entwickler modifizierte Eingabevorlagen mit Unterstützung für Websuche und Dateianalyse — eine Funktion, die zuvor nur in Premium-Kommerzlösungen verfügbar war.

Experten prognostizieren, dass DeepSeek V3-0324 den Markt für KI-Assistenten in der Programmierung und Datenanalyse stören könnte. Seine Open-Source-Verfügbarkeit unter einer MIT-Lizenz öffnet die Tür für Anpassungen — von der Automatisierung von Geschäftsprozessen bis hin zur Schaffung spezialisierter wissenschaftlicher Assistenten.